| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

- 완전탐색

- FastAPI

- pytorch

- GCP

- rnn

- NaverAItech

- 프로그래머스

- wandb

- 네이버AItech

- NLP

- datascience

- Kaggle

- FDS

- 코딩테스트

- autoencoder

- leetcode

- GIT

- torchserve

- pep8

- DeepLearning

- Kubernetes

- GitHub Action

- vscode

- python

- docker

- github

- 백준

- PytorchLightning

- 알고리즘

- Matplotlib

- Today

- Total

Sangmun

RNN BPTT(Back Propagation Through Time) 본문

두번째 심화과제인 Rnn BPTT의 구현이다. 현재의 포스팅에서는 수식만 다룰 예정이다.

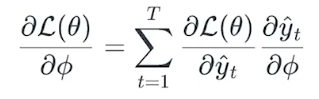

먼저 Rnn BPTT를 이해하는데 도움이 되는 공식이다.

위공식에서 Loss function을 미분하려면 결국은 θ_1에 대하여 미분을 하여야 한다.

그리고 θ_1에 대하여 미분을 하는 경로는 h_2,1,h_2,2두가지 경로가 있는데 θ_1에 대하여 미분을 실시하려면 h_2,1,h_2,2을 미분하여 나온값을 더해줘야 된다는 말이다.

1) Many to one

먼저 하나의 출력값을 가지는 Rnn의 BPTT를 다뤄보려고 한다. 본 예제에서 타임스탭은 4이다.

y_hat은 Rnn의 출력값에서 분류를 위한 layer를 하나더 거친 값을 의미한다.

θ는 Φ(파이)와 ψ(프사이)로 구성되어있고 Φ(파이)는 Rnn의 출력값에서 분류를 위한 추가적인 Layer의 weight를 의미한다.

ψ(프사이)는 Rnn 네트워크의 weight를 의미한다.

2) Many to Many

다음은 Many to Many의 케이스에 대한 BPTT이다.

h_t와 y_hat, θ에 대한 내용은 many to one 네트워크와 동일하며 Loss function과 Rnn 네트워크에 대한 BPTT 내용은 다르게 적용된다.

'네이버 AI 부스트캠프 4기' 카테고리의 다른 글

| 구글 colab vscode에서 접속하기(ngrok) (0) | 2022.09.29 |

|---|---|

| Pytorch Project Template (0) | 2022.09.29 |

| 네이버 AI 부스트캠프 1주차 후기 (0) | 2022.09.25 |

| 최대우도법 정리(Maximum Likelihood Estimation) (0) | 2022.09.25 |

| Gradient descent 직접 구현 (python) (0) | 2022.09.25 |