| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | ||||

| 4 | 5 | 6 | 7 | 8 | 9 | 10 |

| 11 | 12 | 13 | 14 | 15 | 16 | 17 |

| 18 | 19 | 20 | 21 | 22 | 23 | 24 |

| 25 | 26 | 27 | 28 | 29 | 30 | 31 |

- GCP

- wandb

- pytorch

- Kaggle

- pep8

- 완전탐색

- GIT

- Kubernetes

- torchserve

- 코딩테스트

- 알고리즘

- NLP

- FastAPI

- GitHub Action

- FDS

- 네이버AItech

- python

- 백준

- github

- autoencoder

- vscode

- docker

- NaverAItech

- rnn

- DeepLearning

- datascience

- PytorchLightning

- Matplotlib

- leetcode

- 프로그래머스

- Today

- Total

목록분류 전체보기 (120)

Sangmun

[Data Viz] Customizing Matplotlib

[Data Viz] Customizing Matplotlib

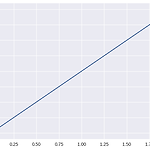

1. mpl.rc https://matplotlib.org/stable/tutorials/introductory/customizing.html mlp.rc로 line의 style을 바꾸어 본다면 아래와 같은 2가지 방법이 있다. import matplotlib.pyplot as plt # 1번째 방법 plt.rcParams['lines.linewidth'] = 2 plt.rcParams['lines.linestyle'] = ':' # 2번째 방법 plt.rc('lines', linewidth=2, linestyle=':') 2. theme matplotlib 에서 기본적으로 사용가능한 theme는 아래와 같으며 print(mpl.style.available) # output ['Solarize_Light..

Pytorch Lightning 사용법 예제로 알아보기

Pytorch Lightning 사용법 예제로 알아보기

Pytorch를 사용하다보면 Tensorflow보다는 사용하기가 편하다는 느낌을 받을 수 있는 데 사용하기 편한 만큼 뭔가 체계화된 구조가 없고 매번 비슷한 코드가 반복된다는 느낌이 있다. (gradien descent라든지.. ,dataloader 부분이라든지..) 따라서 Pytorch Lightning은 Pytorch코드에 대한 high level interface를 제공하고 복잡한 코드들을 추상화하는데 도움을 주기 위해 만들어진 패키지이다. (아래는 Pytorch document) https://pytorch-lightning.readthedocs.io/en/stable/ Welcome to ⚡ PyTorch Lightning — PyTorch Lightning 1.7.7 documentation ..

원래는 Anaconda의 존재 말고는 몰랐었는데 Miniconda의 존재를 알게되어서 해당 포스팅에 글을 남긴다. 실수에서는 Miniconda를 주로 사용하는것 같다. Anaconda와 Miniconda의 차이점은 아래와 같다. 다음과 같은 경우 아나콘다를 선택하십시오 : 콘다 또는 파이썬을 처음 사용함 Python과 150 개가 넘는 과학 패키지가 한 번에 자동으로 설치되는 편리함 시간 및 디스크 공간 (몇 분 및 3GB) 및 / 또는 개별적으로 사용하려는 각 패키지를 설치하고 싶지 않습니다. 다음과 같은 경우 Miniconda를 선택하십시오. 개별적으로 사용하려는 각 패키지를 설치하지 않아도됩니다. 한 번에 150 개가 넘는 패키지를 설치할 시간이나 디스크 공간이 없거나 파이썬과 conda 명령에 빠..

https://arxiv.org/pdf/1508.07909.pdf https://huggingface.co/docs/transformers/tokenizer_summary#subword-tokenization Summary of the tokenizers Reinforcement learning models huggingface.co 개요 단어 단위로 vocab을 구성을 하면 임베딩을 사용할 때 임베딩의 매개변수가 많이 커지게 되는 단점이 있다. 이는 RNN층의 매개변수의 수보다 압도적으로 많게 됩니다. 이런 매개변수 비중의 비대칭성을 해결하기 위해 문자 단위 토큰화가 주목을 받았으나 너무 길어진 sequence와 성능 저하의 문제점이 발생하게 됩니다. 따라서 서브워드 단위로 토큰화를 진행하게 되었는데 ..

[DL basic] LSTM & GRU

[DL basic] LSTM & GRU

http://colah.github.io/posts/2015-08-Understanding-LSTMs/

[NLP] Beam Search

[NLP] Beam Search

https://web.stanford.edu/class/cs224n/slides/cs224n-2019-lecture08-nmt.pdf 보통 NLG 같은 task에서는 자연어를 생성할 때 매 타입스텝마다 decoder를 거쳐서 나온 단어가 다음 타임스텝의 input으로 들어가게 된다. 그리고 decoder에서는 매 타임스텝마다 가장 확률이 높은 단어를 선택해서 출력을 하게 되는데 이것을 Greedy decoding이라고 한다. 하지만 Greedy decoding의 문제점은 매 타임스텝의 최대 확률 값만을 고려하는 것이 전체 타임스텝으로 보면 적절하지 않은 문장을 출력으로 가지게 될 수 있다는 점이다. 그렇다면 greedy decoding에서 하는 방식인 현재 타입스텝만의 확률을 고려하는 방식이 아닌 전체 ..

[NLP] Perplexity(PPL) and BLEU score

[NLP] Perplexity(PPL) and BLEU score

https://wikidocs.net/21697 5) 펄플렉서티(Perplexity, PPL) 두 개의 모델 A, B가 있을 때 이 모델의 성능은 어떻게 비교할 수 있을까요? 두 개의 모델을 오타 교정, 기계 번역 등의 평가에 투입해볼 수 있겠습니다. 그리고 두 모델 ... wikidocs.net BLEU 논문 https://aclanthology.org/P02-1040.pdf PPL PPL은 언어 모델의 평가 metric 중의 하나로 perplexed는 '헷갈리는' 의미를 가지고 있으며 이는 매 타입스텝 마다 몇개의 가능성 있는 output을 가지고 헷갈리냐고 이해할 수 있다. 즉 PPL은 낮을 수록 성능이 좋다라는 의미가 된다. 아래는 PPL의 수식이며 매 타입스텝의 출력값으로 나온 확률 값을 기하평..

https://www.acmicpc.net/problem/14500 14500번: 테트로미노 폴리오미노란 크기가 1×1인 정사각형을 여러 개 이어서 붙인 도형이며, 다음과 같은 조건을 만족해야 한다. 정사각형은 서로 겹치면 안 된다. 도형은 모두 연결되어 있어야 한다. 정사각형의 변 www.acmicpc.net 생성해야 하는 Matrix의 범위가 x축, j => y축 for i in range(a): for j in range(b): for each in polyomino: tmp_sum = 0 flag = 0 # 생성가능한 테트로미노를 순회하면서 임시로 합계값을 계산 for k in each: x = k[0] + i y = k[1] + j if 0