Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

| 29 | 30 | 31 |

Tags

- 백준

- wandb

- 프로그래머스

- python

- NLP

- PytorchLightning

- 코딩테스트

- leetcode

- DeepLearning

- vscode

- pytorch

- pep8

- autoencoder

- FastAPI

- Kaggle

- FDS

- GIT

- GCP

- 알고리즘

- Matplotlib

- NaverAItech

- rnn

- 네이버AItech

- docker

- github

- Kubernetes

- torchserve

- datascience

- GitHub Action

- 완전탐색

Archives

- Today

- Total

Sangmun

[MLOps]pytorch lightning에서 wandb 로깅하기 본문

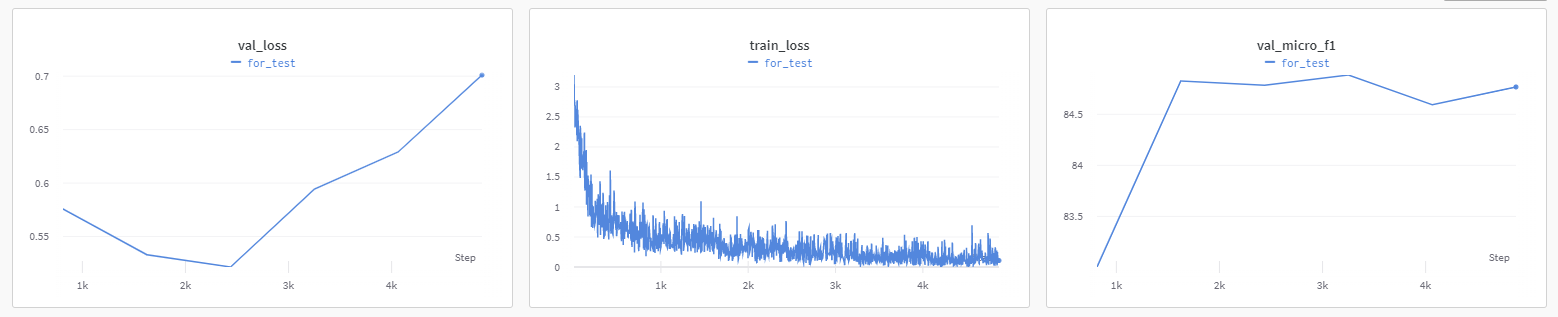

Use PyTorch Lightning with Weights & Biases

In this article, we explore how to use PyTorch Lightning with Weights & Biases so that it's possible to quickly train and monitor models. .

wandb.ai

Pytorch ligntning에서 wandb를 이용하여 실험내용을 로깅하는 것은 매우 간단한다.

아래 코드 처럼 wandb_logger class를 선언만 해주고 trainer에 넘겨주기만 하면 되기 때문이다.

from pytorch_lightning.loggers import WandbLogger

# wandb logger

model = Model(your_model_config)

wandb_logger = WandbLogger(name='wandb 대시보드에서 표시되는 이름',

project='해당 프로젝트 이름',

entity='저장소 이름')

wandb.watch(model)

# ligh

trainer = pl.Trainer(gpus=1, # number of gpu

max_epochs=10, # number of epoch

log_every_n_steps=100, # logging step

logger=wandb_logger # wandb logging

)

기록 하고자 하는 metric등은 pytorch lightning model 안에서 self.log()를 이용하여 기록하는 metric이 되겠다.

def training_step(self, batch, batch_idx):

x, y = batch

logits = self(x)

loss = self.loss_func(logits, y.float())

# self.log() 함수를 이용하여 log를 기록하는 항목들을 wandb_logger가 알아서 받아서

# wandb 대시보드에 시각화 해준다.

self.log("train_loss", loss)

return loss

하지만 맨처음에는 위의 방식으로 로깅을 하면 epoch가 아닌 step별로 로깅이 되는 문제가 있었는데...

이는 그냥 wandb 대시보드에서 x축 항목을 epoch로 바꿔주면 되는 문제였다..

'네이버 AI 부스트캠프 4기 > MLops' 카테고리의 다른 글

| [MLOps] mlflow 기본 사용법 (1) (0) | 2022.11.24 |

|---|---|

| [MLOps]wandb sweep 기본 사용법 (0) | 2022.11.24 |

| [MLOps]Pytorch Monitoring tools (weight & biases) (0) | 2022.09.30 |

Comments